Metodo de maxima verosimilitud

Es un proceso que consiste en utilizar los datos para encontrar estimadores de los distintos parámetros que caracterizan una distribución.

Para entenderlo mejor, pongámonos en la piel de un estadístico. Siendo un estadístico, nuestro trabajo principal es analizar los datos que se nos presentan. Naturalmente, lo primero sería identificar la distribución de la que hemos obtenido nuestros datos.

A continuación, tenemos que utilizar nuestros datos para encontrar los parámetros de nuestra distribución. Un parámetro es una característica numérica de una distribución.

Las distribuciones normales, como sabemos, tienen como parámetros la media (µ) y la varianza (σ2). Las distribuciones binomiales tienen como parámetros el número de ensayos (n) y la probabilidad de éxito (p).

Las distribuciones gamma tienen como parámetros la forma (k) y la escala (θ). Las distribuciones exponenciales tienen como parámetro la media inversa (λ). La lista continúa. Estos parámetros o características numéricas son vitales para entender el tamaño, la forma, la dispersión y otras propiedades de una distribución.

Dado que los datos que tenemos se generan en su mayoría de forma aleatoria, a menudo no conocemos los verdaderos valores de los parámetros que caracterizan nuestra distribución.

Es entonces cuando intervienen los estimadores. Un estimador es como una función de tus datos que te da valores aproximados de los parámetros que te interesan.

La mayoría de nosotros estamos familiarizados con algunos estimadores comunes. Por ejemplo, el estimador de la media de la muestra, que es quizás el estimador más utilizado.

Se calcula tomando la media de nuestras observaciones y resulta muy útil cuando se trata de estimar parámetros que representan la media de su distribución (por ejemplo, el parámetro µ para una distribución normal).

Otro estimador común es el estimador de la varianza de la muestra, que se calcula como la varianza de nuestras observaciones y resulta muy útil cuando se trata de estimar parámetros que representan la varianza de su distribución (por ejemplo, el parámetro σ2 para una distribución normal).

Se puede tener la tentación de pensar que podemos construir fácilmente estimadores para un parámetro basados en la característica numérica que el parámetro representa.

Por ejemplo, utilice el estimador de la media muestral siempre que el parámetro sea la media de su distribución. O utilice el estimador del modo de la muestra si está tratando de estimar el modo de su distribución.

Cinco pasos principales en el MLE

- Realizar un determinado experimento para recoger los datos.

- Elegir un modelo paramétrico de los datos, con ciertos parámetros modificables.

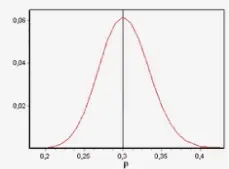

- Formular la probabilidad como una función objetivo que debe maximizarse.

- Maximizar la función objetivo y derivar los parámetros del modelo.

Ejemplos:

Lanzar una moneda – Para encontrar las probabilidades de cara y cruz

Lanzar un dardo – Para encontrar su PDF de distancia a la diana

Muestrear un grupo de animales – Para encontrar la cantidad de animales

Vídeos de Metodo de maxima verosimilitud

Contenido